(Source: IBM)

Lonjakan AI generatif telah membawa berbagai inovasi, mulai dari chatbot yang viral hingga valuasi miliaran dolar. Namun, di balik semua kemajuan ini, fondasi etisnya masih rapuh. Pertanyaan tentang tanggung jawab, keamanan, dan integritas tidak lagi teoretis, melainkan telah menjadi masalah operasional. Kesenjangan antara kemampuan dan kredibilitas ini menjadi inti dari pertimbangan etis yang berkembang di dunia AI, di mana etika sering diperlakukan sebagai lapisan tambahan daripada fondasi struktural.

Etika AI Menurut Pandangan IBM

PJ Hagerty, seorang veteran komunitas pengembang dan AI Advocacy Lead di IBM, berusaha membalikkan pola ini dengan menggabungkan batasan etis secara langsung ke dalam pelatihan, pemasaran, dan penyebaran sistem. Bagi Hagerty, etika harus dimulai lebih awal, yaitu pada tingkat model dasar. Ini adalah infrastruktur mentah AI modern, lapisan dasar machine learning yang dilatih pada dataset besar yang diambil dari web.

“Kami tidak sedang membangun pikiran, Kita sedang membangun alat. Mari kita bertindak seperti itu,” kata PJ Hagerty.

Tujuan Etika AI

Model dasar ini dirancang untuk tujuan umum, sebuah karakteristik yang menjadikannya sangat kuat sekaligus berpotensi berbahaya. Karena tidak dibangun dengan tugas atau batasan spesifik, mereka cenderung menyerap segalanya, mulai dari struktur semantik yang berharga hingga sludge internet yang kotor. Setelah dilatih, model-model ini menjadi sulit diaudit, bahkan para pembuatnya sendiri seringkali tidak dapat memastikan apa yang sebenarnya diketahui model atau bagaimana ia akan merespons prompt tertentu. Hagerty menyamakan kondisi ini dengan menuangkan dasar beton yang cacat untuk sebuah gedung pencakar langit yaitu jika campurannya salah sejak awal, keretakan mungkin tidak langsung terlihat, tetapi seiring waktu, seluruh strukturnya akan menjadi tidak stabil.

Salah satu hambatan etis terbesar menuju kemajuan berarti adalah ketidakjelasan mengenai definisi AI yang digunakan oleh perusahaan. Hagerty melihat kurangnya kejelasan ini sebagai kegagalan etis inti pada era saat ini. Ambigu ini bukan sekadar perdebatan akademis, melainkan krusial karena ketika perusahaan menyajikan perangkat lunak deterministik sebagai penalaran cerdas, pengguna cenderung mempercayainya.

Masalah ini juga berujung pada pemborosan upaya. Hagerty mencontohkan penelitian terbaru tentang penyalahgunaan Model Bahasa Besar untuk peramalan deret waktu, sebuah metode statistik di mana metode klasik sebenarnya lebih akurat dan efisien. Namun, beberapa perusahaan tetap bersikeras menggunakan LLM, seolah hanya mengejar kebaruan atau sekadar ingin menunjukkan inovasi.

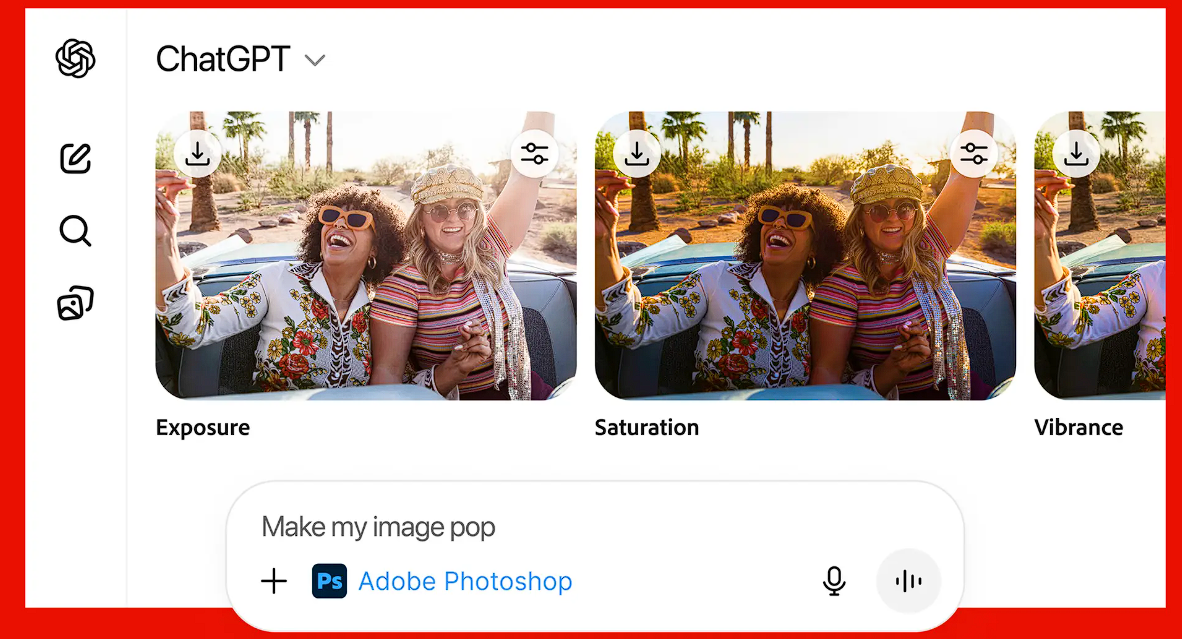

Meskipun kekhawatiran publik seputar AI terfokus pada potensi hilangnya pekerjaan massal, Hagerty melihat pertanyaan ini sebagai prematur dan tidak tepat. Dia menunjuk pada asisten kode seperti watsonx Code Assistant dan GitHub Copilot. Sistem ini tidak menulis seluruh aplikasi dari awal, melainkan mengisi blok kode yang dapat diprediksi, menyarankan boilerplate, dan mengurangi biaya penulisan logika berulang. Keuntungannya bukanlah kreativitas, melainkan kecepatan.

Jangan Isi Fondasi Sistem Dengan Sampah

PJ Hagerty menambahkan, “Fondasi adalah tempat terjadinya, ini adalah hal pertama yang dipelajari oleh sistem, dan jika fondasi penuh dengan sampah, sampah itu tidak akan hilang.”

Hagerty meyakini hal ini positif, namun memperingatkan agar tidak menganggapnya sebagai masalah yang sudah tuntas. Sampah yang dimaksud mencakup kode tidak aman, praktik usang, hack spesifik konteks, serta plagiarisme, pelanggaran lisensi, dan bug tersembunyi yang dapat muncul kembali dalam hasil yang dihasilkan AI. Oleh karena itu, tinjauan manusia tetap penting, sebab akuntabilitas masih berada di tangan pengembang. Baginya, etika bukanlah batasan, melainkan prinsip desain untuk menciptakan perangkat lunak yang lebih baik, sistem yang lebih mudah diprediksi, ekspektasi yang lebih jelas, dan pada akhirnya, nilai yang lebih.