(Source: Freepik)

Pengembangan, pelatihan, penerapan, dan pengelolaan Kecerdasan Buatan (AI) serta beban kerja machine learning (ML) dalam skala besar memerlukan kombinasi perangkat keras dan perangkat lunak yang khusus. Aplikasi AI sangat berbeda dari aplikasi tradisional dalam cara mereka memproses data dan mengonsumsi sumber daya komputasi. Sistem IT tradisional tidak dirancang untuk menangani kebutuhan unik dari beban kerja AI dan ML ini. Oleh karena itu, infrastruktur AI yang tangguh sangat penting bagi pengembang untuk secara efektif menciptakan dan menerapkan aplikasi AI dan ML yang beragam, mulai dari chatbot dan asisten virtual hingga kendaraan otonom, analisis citra medis, pertanian presisi, dan deteksi anomali untuk mencegah penipuan dalam transaksi perbankan.

Laporan F5 Tentang Strategi Aplikasi

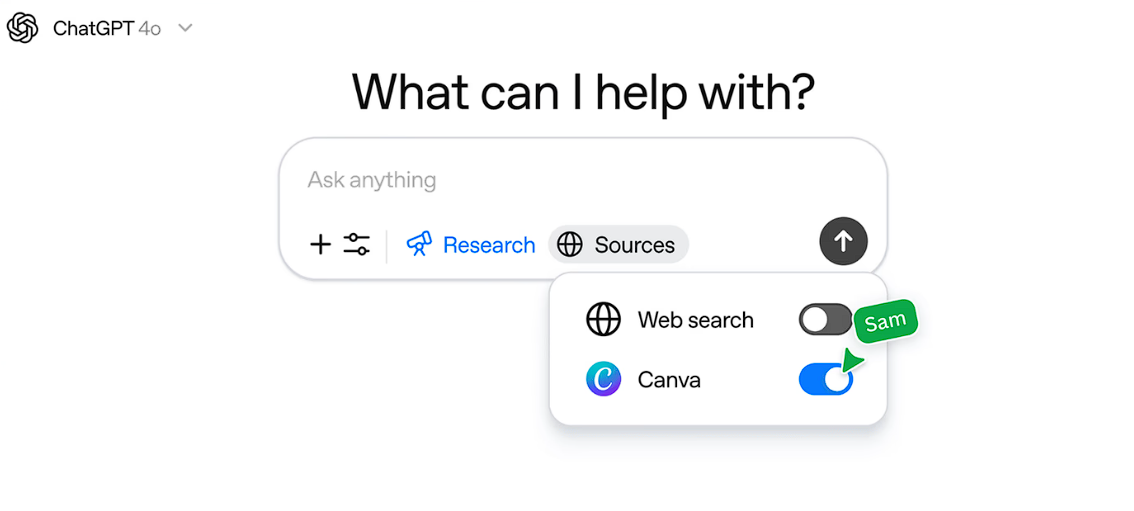

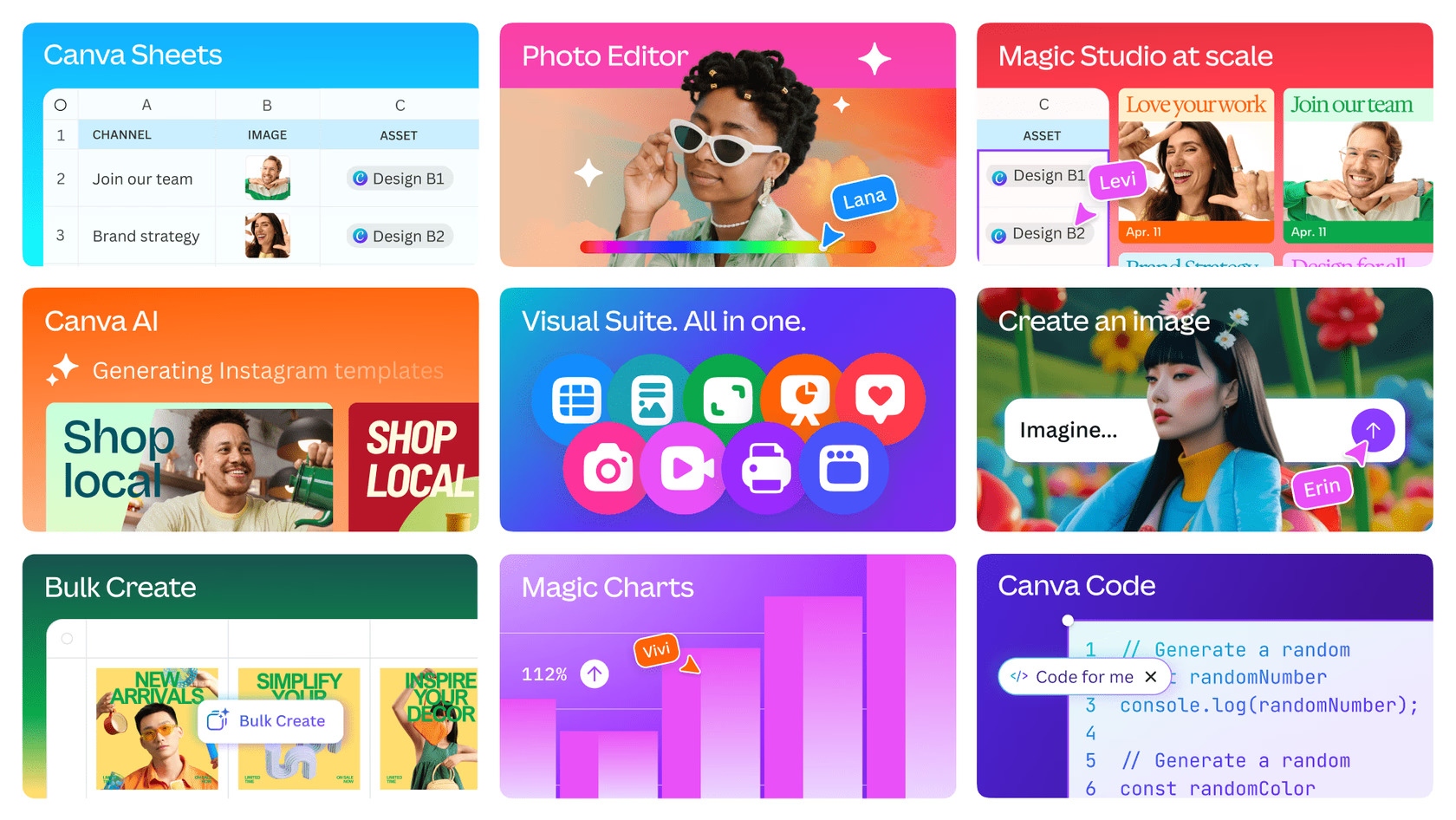

Meskipun memenuhi persyaratan AI memerlukan infrastruktur khusus yang disesuaikan dengan siklus hidup AI, kebutuhan ini tidak memperlambat pertumbuhan investasi dalam AI dan ML. Menurut Laporan Strategi Aplikasi F5 2025, 96% organisasi yang merespons saat ini sedang mendeploy model AI. Selain itu, 71% responden survei The State of AI dari McKinsey mengatakan organisasi mereka secara teratur menggunakan AI generatif dalam fungsi bisnis. AI membutuhkan daya komputasi yang sangat besar yaitu beban kerja AI mengonsumsi dan menghasilkan volume data yang besar, seringkali secara real time.

Infrastruktur AI harus memungkinkan semua komponen inti aplikasi AI di setiap tahap pipeline AI, memastikan kinerja, skalabilitas, dan responsivitas di setiap langkah proses. Ini dimulai dengan penyerapan data, yaitu proses pengumpulan data untuk dimasukkan ke dalam model AI. Langkah ini memerlukan manajemen lalu lintas yang kuat dan bandwidth untuk menangani aliran data high-throughput secara efektif. Setelah penyerapan data, pelatihan model adalah proses berulang untuk membuat model AI baru menggunakan kumpulan data pelatihan. Infrastruktur harus menyediakan kemampuan komputasi yang kuat untuk menyempurnakan model agar memiliki akurasi tinggi saat melakukan tugas tertentu. Inferensi adalah fase runtime di mana aplikasi frontend berinteraksi dengan model AI yang terlatih.

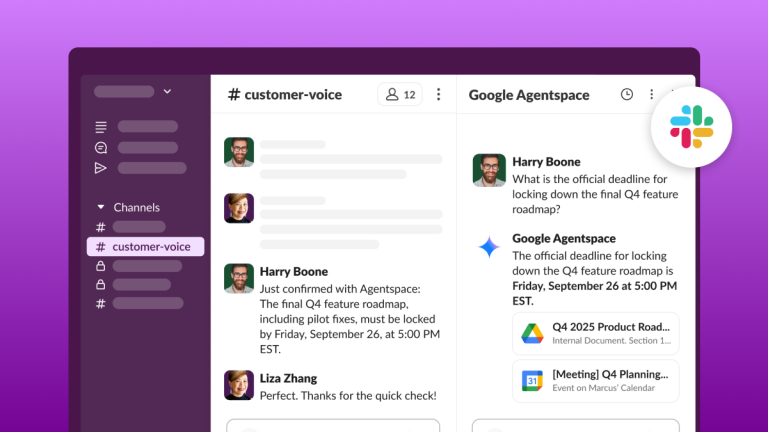

Sistem agen membawa AI melampaui pemrosesan data dan interaksi permintaan atau respons untuk secara proaktif mengambil tindakan tanpa campur tangan manusia. Mendukung AI agen memerlukan orkestrasi lanjutan dan kemampuan pengambilan keputusan real time. Banyak aplikasi AI beroperasi di edge, memungkinkan analitik dan otomatisasi pada perangkat Internet of Things (IoT) seperti sensor, kamera, dan mesin industri. Kasus penggunaan real time ini memerlukan infrastruktur yang dioptimalkan untuk latensi rendah dan pemrosesan terdistribusi yang dekat dengan sumber data.

Perbedaan Infrastruktur AI dan Tradisional

Infrastruktur AI berbeda dari infrastruktur IT tradisional karena memanfaatkan perangkat keras khusus dan platform data untuk memfasilitasi komputasi yang dipercepat dan mendukung kebutuhan komputasi intensif dari beban kerja AI. Sebagai contoh, infrastruktur AI sangat bergantung pada unit pemrosesan grafis, yang dioptimalkan untuk pemrosesan paralel, daripada unit pemrosesan pusat tradisional yang umumnya digunakan dalam sistem IT standar untuk beban kerja tujuan umum. Solusi infrastruktur AI juga menggabungkan perangkat lunak khusus, termasuk pustaka dan kerangka kerja pembelajaran mesin, yang penting untuk mengembangkan, melatih, dan menerapkan model AI. Alat-alat ini tidak umum ditemukan di tumpukan IT tradisional, yang lebih berfokus pada aplikasi perusahaan dan manajemen data.

Jensen Huang, pendiri dan CEO NVIDIA, mengatakan, “AI saat ini merupakan infrastruktur, dan infrastruktur ini, seperti halnya internet, seperti halnya listrik, membutuhkan pabrik. Pabrik-pabrik ini pada dasarnya adalah apa yang kita bangun hari ini. Pabrik-pabrik ini bukanlah pusat data di masa lalu. Anda menggunakan energi, dan menghasilkan sesuatu yang sangat berharga.”

Untuk secara efektif mendukung beban kerja AI dan ML, organisasi menggunakan arsitektur infrastruktur pabrik AI yang dibangun khusus yang mencakup kemampuan komputasi, penyimpanan, dan perangkat lunak khusus. Sumber daya komputasi ini meliputi GPU, yang merupakan inti infrastruktur AI untuk pemrosesan paralel dan penting untuk melatih dan menjalankan model AI yang kompleks. Ada juga unit pemrosesan tensor yang dikembangkan oleh Google, yaitu akselerator AI khusus yang dioptimalkan untuk operasi pembelajaran mesin dan pembelajaran mendalam. Untuk penyimpanan data, ada solusi penyimpanan yang dapat diskalakan karena model AI membutuhkan data pelatihan yang sangat besar. Terakhir, kerangka kerja pemrosesan data seperti Pandas, NumPy, dan SciPy, serta pustaka dan kerangka kerja pembelajaran mesin seperti TensorFlow dan PyTorch, dan platform machine learning operations (MLOps) membantu mengotomatiskan tugas pembelajaran mesin dan mendukung seluruh siklus hidup model.

Banyak organisasi menghadapi rintangan signifikan dalam membangun infrastruktur AI karena pertimbangan biaya dan kerumitan. Hampir separuh responden Survei Indeks Kematangan Perusahaan Digital F5 khawatir tentang biaya pembangunan dan pengoperasian beban kerja AI, sementara 39% mengatakan organisasi mereka belum memiliki praktik data AI yang dapat diskalakan. Untuk mengatasi masalah biaya, mulailah dengan tujuan yang jelas dan anggaran yang terdedikasi. Manfaatkan solusi penyimpanan berbasis cloud dari penyedia seperti AWS, Oracle, IBM, dan Microsoft Azure yang menawarkan model data bayar-sesuai-pakai yang lebih terjangkau. Solusi jaringan juga memiliki peran besar yaitu jaringan high-bandwidth, low-latency memungkinkan pergerakan volume data yang besar antara sistem penyimpanan dan sumber daya komputasi.